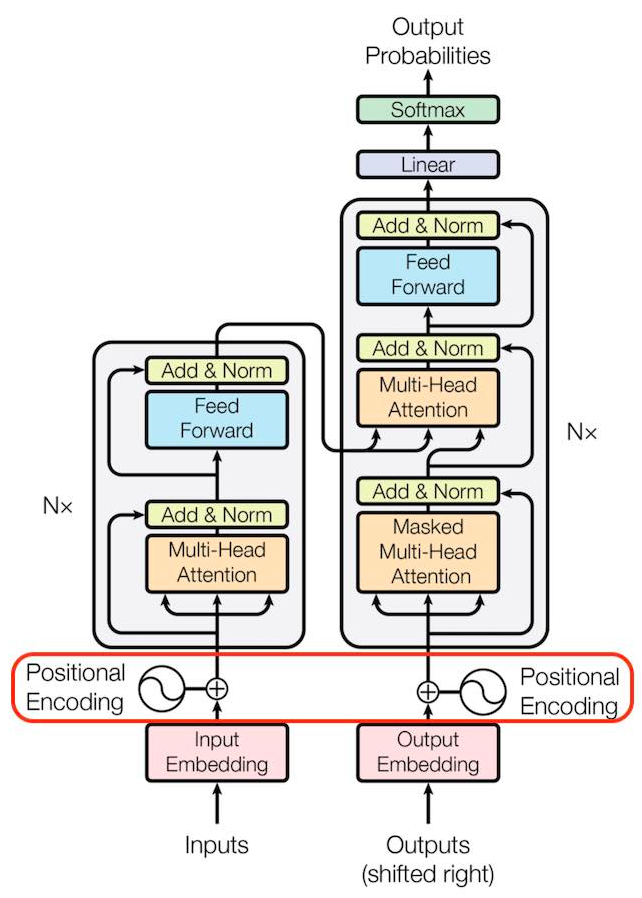

Transformer 기반의 모델들이 우수한 성능을 보여주면서 그 활용도가 점점 높아지고 있다. 그리고 Transformer 모델을 소개하는 논문 "Attention is All You Need"에서 Positional Encoding라는 방법 또한 처음 등장하게 되었다. 이후 Transformer 기반의 자연어 모델들이 우수한 성능을 보였고 BERT 모델에서는 Positional Embedding을 사용하였다. 그러나 요즘 Positional Encoding과 Positional Embedding에 차이가 있음에도 이를 혼용하여 사용하고 있는것 같아 이에 관해 자세히 정리해보려고 한다.🟥 Encoding / Embedding먼저 Encoding과 Embedding이 무엇인지 어떤 차이가 있는지부터 확..